A confiança que antes tínhamos nos vídeos como registros fiéis da realidade está cada vez mais abalada. Com o avanço dos deepfakes, qualquer pessoa com um computador razoável consegue criar imagens falsas de líderes mundiais falando o que nunca disseram ou recriar eventos que jamais aconteceram. É um cenário preocupante, mas pesquisadores da Universidade Cornell acreditam ter encontrado uma forma engenhosa de combater essa ameaça, e a arma escolhida é algo tão comum quanto a luz.

A técnica, chamada de noise-coded illumination, usa padrões de piscadas imperceptíveis a olho nu para “marcar” vídeos com um tipo de assinatura digital quase impossível de falsificar. O método, desenvolvido pelo professor assistente Abe Davis e pelo estudante de pós-graduação Peter Michael, faz com que as fontes de luz emitam um código secreto. Esse código é registrado por qualquer câmera presente no ambiente, desde celulares até equipamentos profissionais, sem precisar de ajustes especiais. Se a luz está na cena, o “carimbo” invisível está lá também.

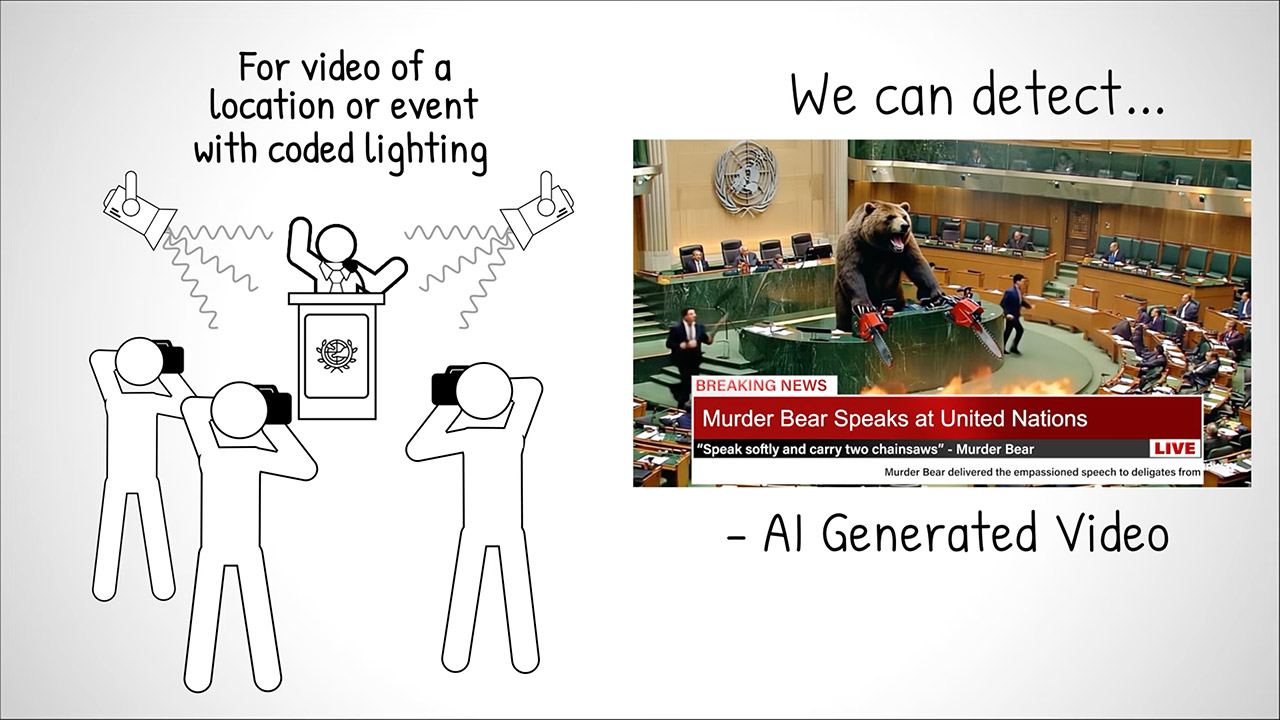

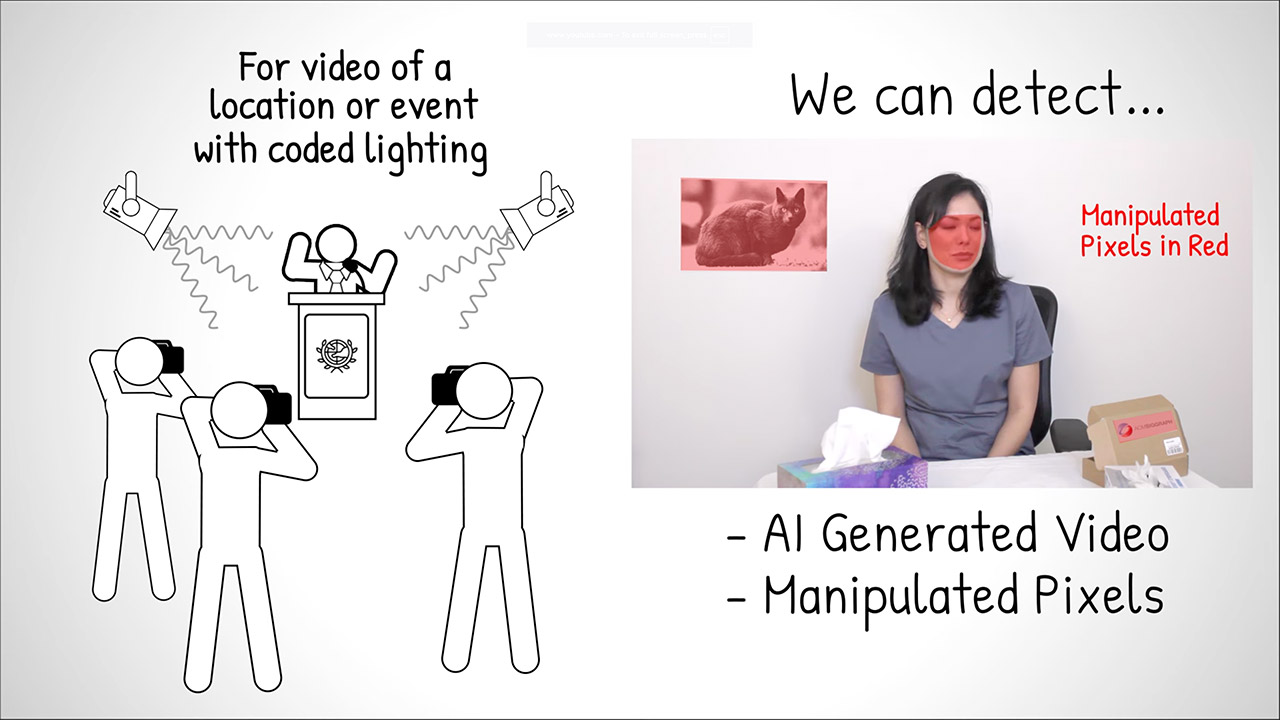

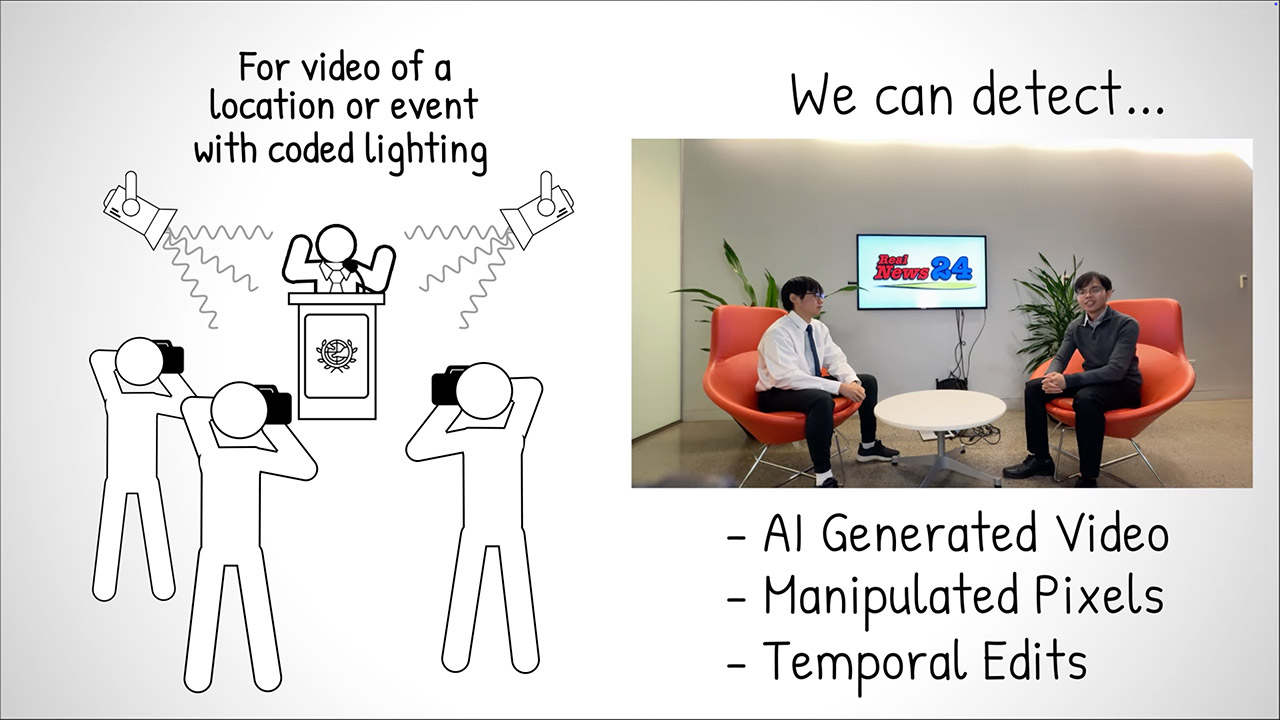

O funcionamento é engenhoso: imagine uma coletiva de imprensa ou entrevista iluminada por luminárias comuns, ou até pela tela de um computador. Essas fontes de luz são programadas para pulsar de forma extremamente sutil, inserindo no vídeo uma versão em baixa resolução e com marcação temporal da própria gravação, algo como uma “cópia fantasma” oculta na iluminação. Quando um especialista analisa o material com a chave correta, pode extrair essa versão oculta e compará-la com o vídeo principal. Se as duas batem, a gravação é legítima; se houve manipulação, a cópia revela falhas, trechos faltando ou distorções claras.

O melhor é que a tecnologia não depende de equipamentos futuristas: lâmpadas inteligentes e monitores modernos podem ser programados via software, enquanto modelos antigos podem receber um chip minúsculo para ganhar essa capacidade. E a segurança pode ser reforçada usando várias fontes de luz com códigos diferentes ao mesmo tempo, tornando o trabalho de falsificadores quase impossível.

Os testes, que serão apresentados no SIGGRAPH 2025, mostraram que o sistema funciona em ambientes variados, tanto internos quanto externos, e para diferentes tons de pele, sem perder eficácia. Nos experimentos, qualquer tentativa de corte, edição ou substituição de rostos ficou evidente na “cópia fantasma”. No caso de um deepfake gerado do zero, o código simplesmente não gerava uma versão coerente, denunciando a fraude.

Os pesquisadores reconhecem que essa é uma corrida constante contra a desinformação, para cada nova defesa, surgem tentativas de burlar o sistema. Porém, replicar exatamente o padrão de luz exigiria conhecer todos os códigos e aplicá-los em cada fonte de iluminação da cena, algo altamente complexo. Além disso, o piscar é tão discreto que é praticamente impossível perceber a olho nu.

Essa abordagem coloca uma nova camada de segurança sobre um dos formatos mais vulneráveis da era digital, provando que, às vezes, a melhor forma de iluminar a verdade é literalmente com luz.

Veja mais sobre web.